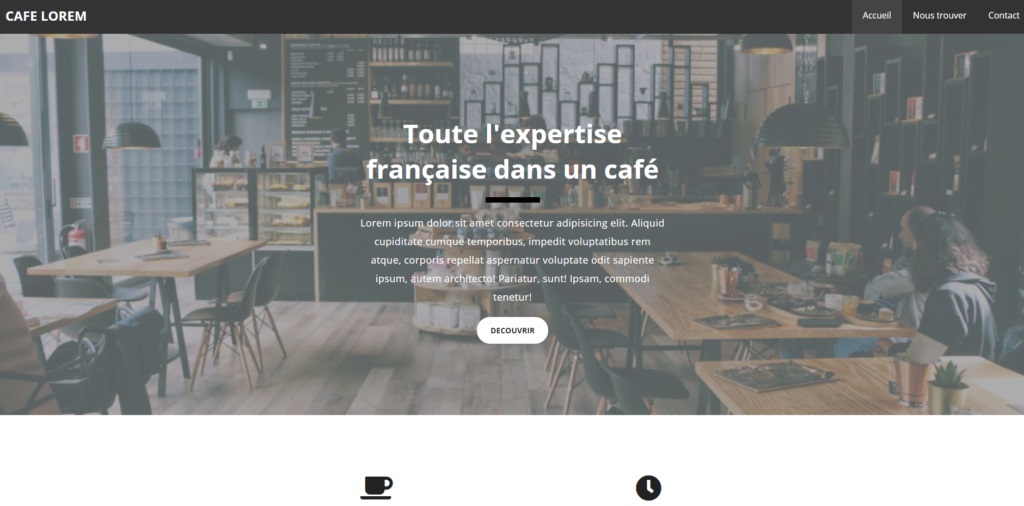

Template type café/restaurant, moderne et sobre

Laion-5B, une banque d’images utilisée pour entraîner certaines intelligences artificielles (IA) génératives, contenait plus d’un millier d’images pédopornographiques, selon une étude de l’université américaine Stanford, parue mercredi 20 décembre et révélée par le site spécialisé 404 Media.

Sur les quelque cinq milliards de fichiers que renferme cette base de données, constituée d’une vaste quantité d’images et de descriptions issues de documents postés publiquement en ligne, le Stanford Internet Observatory en a identifié 3 200 potentiellement problématiques. Avec l’aide du Centre canadien de protection de l’enfance, un peu plus d’un millier d’entre elles ont finalement été considérées comme illégales et signalées aux autorités.

Le fait que de telles images aient pu se retrouver dans ce jeu de données est problématique, estime le rapport, car les outils qui se fondent sur elle peuvent alors permettre de créer de nouvelles images pédopornographiques, potentiellement réalistes. Lancée en mars 2022, Laion-5B a notamment été utilisée pour entraîner l’outil de génération d’images Stable Diffusion.

L’ONG allemande Large-scale Artificial Intelligence Open Network (Laion), qui gère ces données d’entraînement, a pris dès mardi la décision d’en retirer temporairement l’accès sur Internet, avec pour objectif d’en éliminer les contenus délictueux. Dans un communiqué posté sur son site Internet, la veille de la publication du rapport de Stanford, l’organisation assure ainsi avoir « une tolérance zéro pour les contenus illégaux », annonçant son intention de vérifier que les jeux de données de Laion « sont sûrs, avant de les republier ».

Le problème ne sera pas facile à régler, estime cependant David Thiel, l’un des chercheurs à l’origine du rapport, auprès de l’agence Associated Press. Bon nombre d’intelligences artificielles ont en effet été entraînées avec ce jeu de données et « lancées avec précipitation sur le marché », estime-t-il. Dans le cas de Stable Diffusion, sa version 2.0 a certes été conçue à l’aide d’une version filtrée de ses contenus problématiques, ce qui rend difficile de l’utiliser pour générer des contenus pornographiques. Mais une version antérieure, Stable Diffusion 1.5, est toujours utilisée par certaines communautés en ligne pour créer ce type d’images.

Stability AI, la société qui gère Stable Diffusion, a assuré mercredi utiliser des « filtres rigoureux » pour expurger Laion de tout contenu problématique, et assure œuvrer à leur amélioration. Le Stanford Internet Observatory, lui, considère que des mesures plus drastiques sont nécessaires et appelle toutes les entités ayant conçu des outils de génération d’images à partir de Laion-5B à « les supprimer ou à travailler avec des intermédiaires pour les nettoyer ». Les chercheurs considèrent également comme essentiel de faire disparaître d’Internet les versions les plus anciennes de Stable Diffusion, appelant à la responsabilité des plates-formes qui les hébergent.

Aucun commentaire n'a été posté pour l'instant.